日前,2024中国绿色算力(人工智能)大会在呼和浩特召开。人工智能(AI)、算力和绿色都是今年数据中心领域的热门话题,大会上发布的超聚变FusionPoD for AI新一代全液冷整机柜GPU服务器便向我们展示了这三个关键词结合的样子。

据悉,三年前,超聚变就携业界首创液冷整机柜服务器扎根于内蒙这片算力勃发的土地上。目前,已经实现了全国超7万节点的规模商用,FusionPoD也历经了多次迭代,从通算、智算演进到通算与智算兼容。

2023年初发布的FusionPoD液冷整机柜服务器在机柜背面做足功夫,确立了该系列产品的核心架构:一是首创电、网、液三总线盲插设计,节点正面插入,供电、散热、联网三大需求同时解决,还可以支持无人化机器人自动运维;二是机柜后门近端换热,简化了数据中心机房侧的制冷系统,体现了架构级L0/L1/L2融合创新的优势。

最初面向通用计算(通算)的FusionPoD液冷整机柜服务器,单柜可达32~36个1U节点,每节点可配置4个CPU,采用高密铲齿冷板,单芯片散热能力超过800瓦,单柜功率达33~75千瓦(kW),风冷部分的热量由液冷背门带走,在机柜层面实现了全液冷,消除对列间空调或机房空调的需求,简化机房侧的基础设施。

超聚变智能数据中心总经理王广京表示,数据中心运营的核心因素有两个,即单芯片的功耗和整机柜的功耗。目前单芯片的功耗,CPU已经从350瓦向500瓦进发,GPU则从700瓦来到1200瓦,未来还会更高。在这个过程中,风冷架构不仅要解决工程实现的问题,还会带来额外的成本改变。

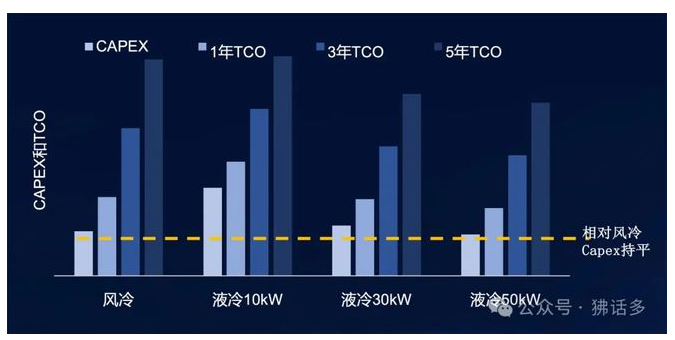

液冷能够减少服务器散热相关环节的能源消耗,从而降低数据中心的运营支出(OPEX),这是大家的一个共识。但是大家可能还有另一个共识,即新技术的应用一定会带来CAPEX(资本支出)的增加。

然而,超聚变的数据有助于我们打破这一误区,即随着单机柜的功耗一路增长到50千瓦的时候,风冷和液冷的CAPEX就已持平;回退一步到单机柜30千瓦的情况,以一年的TCO来计,液冷也要优于风冷,后面都是赚到。

超聚变在2023年下半年推出面向智能计算(智算)应用的FusionPoD for AI,通过增大PSU的功率和数量,可以提供105千瓦的供电容量,支持8个4U的8 GPU节点,共64个GPU,在液冷背门的配合下,pPUE低至1.06。

进入2024年,随着英伟达发布B200芯片和GB200 NVL72整机柜,FusionPoD for AI也相应地上调了几个基本参数,如1500瓦单芯片散热,单柜可达72个GPU、功率120千瓦,GPU模组和PCIe形态兼容、GPU节点可选4U和1U,配合112~224G柜内高速铜缆互联,形成了对NVIDIA GB200 NVL72的全包围。

不过,决定FusionPoD for AI被称为“新一代全液冷整机柜GPU服务器”的关键,还属“一个重构,两大升级”:

重构发生在集群管理系统,在一套硬件架构或者说硬件形态上,实现了东西方算力的即插即用,兼容英伟达和其他厂商的GPU或加速器;

升级都在整机柜的冷却系统,首先是基于超聚变柔性冷板技术的突破,从节点中移除了风扇,实现节点级全液冷不仅有静音的优点,还可以将IT设备侧的功耗再降低5%~10%,这不会体现在PUE指标上,但能带来实实在在的节能效果;

既然不需要风液交换了,液冷背门也就可以升级为分布式CDU,不占U位换热,更重要的是一次侧的液体可以直接进机柜,免除复杂的二次侧施工、验证等工作,实现高效和极简部署。

超聚变FusionPoD for AI新一代全液冷整机柜GPU服务器将在年底前上市。四川超聚变服务器总代理-成都超聚变服务器代理商-电话18380340551

英伟达等科技股的波动率,近期急速上升。上周五该股一天就蒸发了一个贵州茅台,而隔夜又大涨6000亿元,但关于英伟达的多空之争并没有停止,多头认为AI行情还只是第一阶段,而空头却担忧B100的出货量像其他芯片股一样Miss。

四川超聚变服务器代理商

FusionServer 1288H V5是一款1U2路机架服务器,适用于云计算虚拟化、高性能计算(HPC)、大数据处理等负载的高密度部署,提升数据中心空间利用率。

超聚变FusionServer 1288H V6是一款1U2路机架服务器,适用于云计算、虚拟化、高性能计算、大数据处理等负载的高密度部署,提升数据中心空间利用率。

超聚变1288H V7服务器适用于IT核心业务、云计算、虚拟化、高性能计算、企业或电信业务应用及其它复杂工作负载。

超聚变FusionServer 2288H V7(以下简称2288H V7)是针对SDS、VDI、CDN、虚拟化、大数据、数据库、云场景、AI 推理、小型企业、OA、Web应用业务应用等需求,推出的具有广泛用途的新一代2U2路机架服务器,满足企业或电信业务应用及其它复杂工作负载。

超聚变FusionServer 2288H V6是一款2U2路机架服务器,配置灵活,可广泛适用于云计算、虚拟化、数据库、大数据等负载。

2288 V7适用于IT核心业务、云计算、虚拟化、分布式存储、大数据处理、企业或电信业务应用及其它复杂工作负载。

超聚变FusionServer 2288H V5是一款2U2路机架服务器,配置灵活,配备24个DDR4内存扩展插槽与10个PCIe扩展槽以及最多20×3.5英寸或31×2.5英寸的本地存储资源(可配置4/8/12/24/28个NVMe SSD硬盘)

FusionServer 5298 V7(以下简称5298 V7)是针对互联网、运营商、金融、政企等行业需求,推出的具有广泛用途的新一代4U2路机架服务器。

是针对互联网、IDC(Internet Data Center)、云计算、企业市场以及电信业务应用等需求,推出的具有广泛用途的新一代4U2路机架服务器。

【国产服务器 算力更强劲】超聚变FusionServer 5288 V6是一款4U2路机架服务器,满足温冷存储需求,视频分析存储型服务器首选!

超聚变FusionServer 5288 V5是一款4U双路或单路存储型机架服务器,适用于冷数据存储、视频监控、云存储、大数据等应用场景。

FusionServer 2298 V5是针对互联网、企业市场以及运营商市场等需求,推出的具有广泛用途的新一代2U2路机架服务器。

超聚变FusionServer 2488 V5服务器,具有高性能计算、大容量存储、低能耗、扩展能力强、高可靠、易管理、易部署、支持虚拟化等优点。

超聚变FusionServer 2488H V7服务器针对IDC(Internet Data Center)、云计算、企业市场以及电信业务应用等需求,推出的具有广泛用途的2U4路机架服务器。

超聚变FusionServer 2488H V6是最新推出的2U4路机架服务器,适用于云计算、虚拟化、高性能计算(HPC)、数据库、SAP HANA等计算密集型场景。